Несколько недель назад я обратился в фирму по набору текста. У меня было много рукописного материала, который мне необходимо было перевести в электронный вид. Оператор по телефону вежливо ответил на все вопросы и попросил отправить на электронную почту образец отсканированного листа для ознакомления.

Я с техникой дружу плохо, поэтому я попросил прислать мне курьера, чтобы он забрал у меня рукопись. Через два часа ко мне приехал мальчик, я ему отдал мой материал. Через пару часов мне позвонил менеджер, рассказал про общий объем набора, озвучил стоимость набора текста и сделал скидку за большой заказ. Я поинтересовался, в какой срок мне выполнят заказ, мне пообещали за три дня. Я очень удивился, ведь там было более ста страниц рукописного текста. Но меня заверили, что для них это обычная практика.

Через три дня, со мной связался менеджер Николай и объяснил, что заказ выполнен, и что я могу приехать, чтобы его забрать или вызвать курьера. Я, конечно, согласился на выезд доставщика, так как у меня не было времени ехать, чтобы забрать готовый электронный вид и мои рукописные материалы.

Вечером того же дня ко мне приехал человек и привез компакт диск с записанным документом набранного текста и мою рукопись. Я вставил диск в компьютер, проверил, что весь текст, который мне нужен был в программе Word. Я расплатился и отпустил его с миром.

После ухода представителя организации я весь вечер читал набранный текст, хочу сказать, что я удовлетворен. Я не нашел ни одной ошибки и опечатки. Весь текст был правильно отформатирован. Очень был удивлен, что мой почерк легко разобрали и перенесли в компьютер. Раньше мне приходилось ждать неделями каких-то 40 страниц. В этой организации мне намного больше понравилось. Буду и впредь обращаться.

Абрамцев Виктор Николаевич г.Москва

Абрамцев Виктор Николаевич г.Москва

Я студент, все рефераты и курсовые я писал самостоятельно. Но в преддверии дипломной работы, когда необходимо было подготовить печатный текст намного больше, чем обычный доклад, я решил, что перепечатывать его в компьютер будет очень долго и мучительно. Ведь скорость моего набора не превышает 50 знаков в минуту. Поэтому я решил, что лучше отдам его для набора другим людям, которые этим занимаются. В интернете я начал искать фирму.

Мне нужно было сделать услугу качественно и быстро, ведь сроки уже поджимали. Поэтому мне необходимо было найти компанию с хорошей репутацией. Я зашел на сайт Яндекс, набрал запрос набор текстов отзывы, и начал искать хорошие и плохие отзывы о работе организаций по набору текста. Я наткнулся на сайт набор-текта.рф, ни одного плохого отзыва я не нашел, все только хвалили. После чего я связался с ними и оставил заявку на выполнение задания.

Через несколько дней мой диплом был уже набран. Я полностью проверил. Нашел одну опечатку на 57 странице из 300. Я остался доволен. В этой компании действительно трудятся пунктуальные профессионалы своего дела. Диплом я защитил на отлично.

Теперь я буду постоянно обращаться, и рекомендовать своим друзьям и знакомым.

Муравьев Александр г.Воронеж

Муравьев Александр г.ВоронежОчень часто я нуждаюсь в услугах по набору рукописного текста. Но найти компанию по перепечатыванию текста с хорошими отзывами не так легко. Раньше я обращалась в ближайший дом быта, где мне оказывали подобную работу. Сейчас там ни кого нет. В городе больше такие услуги не предоставляют. Сама я набирают текст очень медленно. Поэтому приходиться мучатся. Но недавно я узнала, что можно отсканировать текст, отправить его на электронную почту и тебе в ответ придет готовый набранный текст. Я обратилась к ним, цены меня приятно удивили. Намного дешевле, чем с меня брали в моем городе. Я для проверки отправила им страницу рукописного текста, со мной связался менеджер, подтвердил заявку и уже через несколько часов мне прислали готовый материал в Word-е. Я очень обрадовалась, наконец-то моим мукам пришел конец.

Теперь я постоянно пользуюсь услугами данной компании.

Несколько недель назад я обратился в фирму по набору текста. У меня было много рукописного материала, который мне необходимо было перевести в электронный вид. Оператор по телефону вежливо ответил на все вопросы и попросил отправить на электронную почту образец отсканированного листа для ознакомления.

Я с техникой дружу плохо, поэтому я попросил прислать мне курьера, чтобы он забрал у меня рукопись. Через два часа ко мне приехал мальчик, я ему отдал мой материал. Через пару часов мне позвонил менеджер, рассказал про общий объем набора, озвучил стоимость набора текста и сделал скидку за большой заказ. Я поинтересовался, в какой срок мне выполнят заказ, мне пообещали за три дня. Я очень удивился, ведь там было более ста страниц рукописного текста. Но меня заверили, что для них это обычная практика.

Через три дня, со мной связался менеджер Николай и объяснил, что заказ выполнен, и что я могу приехать, чтобы его забрать или вызвать курьера. Я, конечно, согласился на выезд доставщика, так как у меня не было времени ехать, чтобы забрать готовый электронный вид и мои рукописные материалы.

Вечером того же дня ко мне приехал человек и привез компакт диск с записанным документом набранного текста и мою рукопись. Я вставил диск в компьютер, проверил, что весь текст, который мне нужен был в программе Word. Я расплатился и отпустил его с миром.

После ухода представителя организации я весь вечер читал набранный текст, хочу сказать, что я удовлетворен. Я не нашел ни одной ошибки и опечатки. Весь текст был правильно отформатирован. Очень был удивлен, что мой почерк легко разобрали и перенесли в компьютер. Раньше мне приходилось ждать неделями каких-то 40 страниц. В этой организации мне намного больше понравилось. Буду и впредь обращаться.

Я студент, все рефераты и курсовые я писал самостоятельно. Но в преддверии дипломной работы, когда необходимо было подготовить печатный текст намного больше, чем обычный доклад, я решил, что перепечатывать его в компьютер будет очень долго и мучительно. Ведь скорость моего набора не превышает 50 знаков в минуту. Поэтому я решил, что лучше отдам его для набора другим людям, которые этим занимаются. В интернете я начал искать фирму.

Мне нужно было сделать услугу качественно и быстро, ведь сроки уже поджимали. Поэтому мне необходимо было найти компанию с хорошей репутацией. Я зашел на сайт Яндекс, набрал запрос набор текстов отзывы, и начал искать хорошие и плохие отзывы о работе организаций по набору текста. Я наткнулся на сайт набор-текта.рф, ни одного плохого отзыва я не нашел, все только хвалили. После чего я связался с ними и оставил заявку на выполнение задания.

Через несколько дней мой диплом был уже набран. Я полностью проверил. Нашел одну опечатку на 57 странице из 300. Я остался доволен. В этой компании действительно трудятся пунктуальные профессионалы своего дела. Диплом я защитил на отлично.

Теперь я буду постоянно обращаться, и рекомендовать своим друзьям и знакомым.

Муравьев Александр г.Воронеж

Муравьев Александр г.ВоронежОчень часто я нуждаюсь в услугах по набору рукописного текста. Но найти компанию по перепечатыванию текста с хорошими отзывами не так легко. Раньше я обращалась в ближайший дом быта, где мне оказывали подобную работу. Сейчас там ни кого нет. В городе больше такие услуги не предоставляют. Сама я набирают текст очень медленно. Поэтому приходиться мучатся. Но недавно я узнала, что можно отсканировать текст, отправить его на электронную почту и тебе в ответ придет готовый набранный текст. Я обратилась к ним, цены меня приятно удивили. Намного дешевле, чем с меня брали в моем городе. Я для проверки отправила им страницу рукописного текста, со мной связался менеджер, подтвердил заявку и уже через несколько часов мне прислали готовый материал в Word-е. Я очень обрадовалась, наконец-то моим мукам пришел конец.

Теперь я постоянно пользуюсь услугами данной компании.

Елена М. г.Белгород

Елена М. г.БелгородНабор текста на дому — очень желанный способ заработка для большинства новичков со знанием компьютера. Сидишь себе за монитором, перепечатываешь какие-то статьи или книги, и получаешь за это деньги, казалось бы — все просто и логично! Но не тут то было,

Быстрая навигация:

Схема обмана

Схем обмана связанных с этой темой великое множество, расскажем о двух самых распространенных.

Обман первый: Вы откликаетесь на одну из подобных вакансий, в ответ вам присылают список заданий, где все подробно расписано: тематика задания, количество листов, размер оплаты, срок исполнения, формат файла. И самое главное — указана сумма страховки, которую необходимо перечислить на счет работодателя! Объясняется это тем, что взнос взимается по причине безответственных работников, мол есть люди, которые берут заказ и не выполняют его. Для этого и нужна «страховка» которая идёт на счёт заказчика, как неустойка.

Разумеется никакая страховка никуда не идет, да и задание ваше никто проверять не будет. После перечисления денег работодатель пропадает, и никогда больше не выйдет на связь.

Пример мошеннических вакансий

Пример мошеннических вакансийОбман второй: Вы находите «работодателя», обсуждаете с ним делали работы, вам предлагают сотрудничать, но с одним но! Работодатель говорит: «У нас так много кандидатов на эту работу, что мы стали вынуждены брать предоплату, чтобы нас не кинули. Разумеется мы вернем Вам всю эту предоплату с первой же зарплатой.»

Как вы уже наверное догадались, никто ничего не вернет, да и собственно, первой зарплаты не будет.

Вариаций множество, вам могут предложить получить материалы для перепечатки пересылкой по почте, или даже вручить лично после оплаты «страховки», либо какого-то необходимого взноса для оформления вас на работу и т.п. При этом оплата труда будет обещана очень достойная, сравнимая с зарплатой специалистов в разных областях. Ну, на обещания все щедры, побольше желающих набежит. А вот суть одна, 90% сайтов и вакансий по набору текста — это обман и лохотрон.

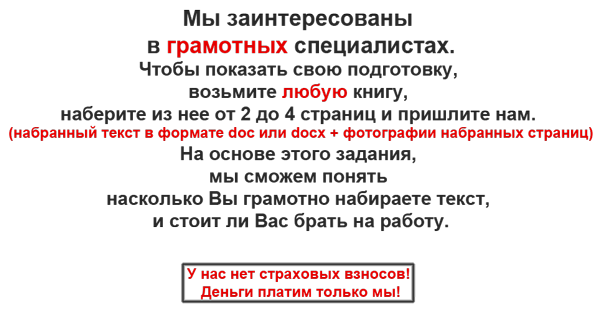

Чтобы рассмотреть Вас как потенциального работника, мы должны понимать Вашу квалификацию, понять, насколько Вы грамотно набираете текст. Если вы хотите получить удаленную работу, мы обязаны Вас попросить взять любую книжку и набрать из нее от 2 до 4 страниц текста. Далее необходимо прислать нам этот текст в формате doc или docx + прикрепить фотографии набранных страниц. Либо Вы можете написать сочинение на любую тему.

На основе этого задания, мы сможем понять насколько Вы грамотно набираете текст, и стоит ли Вас брать на работу.

После выполнения проверочной работы, прикрепите текстовый файл и фотографии через форму на этой странице.

Проверка тестовой работы — БЕСПЛАТНО

Проверка длится до 10 рабочих дней. Даже самая грамотная работа не дает 100% гарантию, что именно Вам будет предоставлена эта должность. Каждую неделю мы выбираем только одного сотрудника. Всем остальным мы вынуждены отказать.

Результат проверочной работы, можно узнать на этой странице нашего сайта набор-текста.рф/proverka-sochineniya.html (напоминаем, что в связи с большой загруженностью, проверка длится до 10 рабочих дней (суббота и воскресенье — выходные, они не считаются).

Запомните! Чтобы получить удаленную работу надо показать, на что Вы способны, а не перевести деньги на чужой интернет кошелек. Мы никогда не требуем у соискателей перевода денег!

Москва: +7 (499) 409-82-43 СПБ: +7 (812) 947-98-23 другие города

Как работают RFID и RF метки?

Крис Вудфорд. Последнее обновление: 23 августа 2019 года.

Сколько раз вы проходили через Двери магазина и, к вашему крайнему смущению, включить сигнализацию? Это удивительно легко сделать, даже если вы заплатили за товар и имели его «деактивирован» на кассе. Противоугонные сигналы используют технология называется RF (радиочастотная) , в то время как аналогичная (но более продвинутая) технология под названием RFID (радиочастотная идентификация) имеет много других применений, от отслеживания домашних животных и инвентаризации публичной библиотеки до сбора платы за проезд от пассажиров автобуса.Давайте подробнее рассмотрим эту хитрую технологию и выясним, как она работает!

Фото: типичные ворота безопасности RF в дверях магазина в Лондоне, Англия. Есть еще один из них на другой стороне двери. Иногда эти сканеры замаскированы, поэтому вы не можете их видеть, но чаще они предназначены для того, чтобы действовать как очень заметный сдерживающий фактор для магазинных воров.

Беспроводной мир

Радио или беспроводная связь — это способ передачи энергии через пустое пространство, то есть вместо использования проводного кабеля.Энергия несут невидимые волны электричества и магнетизм, который вибрирует через воздух со скоростью света. Фундаментальная наука и практическая Технология беспроводной связи была разработана во второй половине 19-го века. В начале 20-го века «радио» стало означать аудиопрограммы, передаваемые по воздуху от гигантских передатчиков к громоздкие электронные ящики, сидящие в домах людей. Когда изобретатели нашел способ отправки картинок, а также аудио, на телевидении родился.Сегодня все виды вещей работают с использованием одной и той же беспроводной технологии, от цифрового радио и телевидения до мобильных телефонов (мобильных телефонов) и беспроводного Интернета.

Радио и телевидение предполагают передачу радиоволн в одном направлении. только: от передатчика на радиостанции или телевизионной станции до приемника (радио или телевизор) в вашем доме. Беспроводной интернет и мобильные телефоны являются более сложными, потому что они включают в себя двустороннюю связь. Ваш сотовый телефон, например, содержит как радиоприемник (чтобы взять входящий сигнал от собеседника) и радио передатчик (чтобы отправить свой голос другому человеку).Радар есть другая технология, которая использует радиоволны. Самолеты и корабли оснащены радиолокационные передатчики посылают лучи радиоволн и слушают эхо — отраженные радиолуча, отражающиеся от других самолетов и кораблей рядом, поблизости. Противоугонные устройства немного похожи на радар: они излучают радио выходит в магазин в надежде поймать украденную книгу или CD, как он проходит мимо. Но как точно они работают?

Фото: пример типа метки RFID, используемой на этикетках книг.Он помогает с автоматическим контролем складских запасов и (в некоторых системах) может использоваться как противоугонное устройство. Вы можете часто видеть их, держа книги в мягкой обложке библиотеки до света. Этот тег представляет собой UPM Raflatac RaceTrack, который может содержать до 1 килобайта (1024 символов) информации. Он работает на относительно высокой частоте радиоволн 13,56 мегагерц.

Как работает РФ

Представьте, что ваша миссия состоит в том, чтобы спроектировать устройство против кражи, используя некоторые старые радиоприемники, которые вы нашли в гараже.Вы можете построить что-то вроде радар (с комбинированным радиопередатчиком и приемником), сидеть у входа в магазин, и указать на людей, проходящих мимо. Радиоволны выходят из ваш передатчик, отскочить от людей, проходящих мимо, а затем отразить назад на ваш радиоприемник. Проблема в том, что это на самом деле не скажет вам ничего полезного, потому что каждый будет отражать радиоволны в точно так же! Вы не знали бы, были ли люди воровством или нет, потому что не было бы никакого способа отличить магазинных воров от обычные клиенты или люди, которые вообще ничего не покупали.какой вам действительно нужно, чтобы магазинные воры отражали радиоволны в другой способ для всех остальных. Но как?

Фото. Внимательно посмотрите на этикетку с указанием цены и размера на паре обуви, и вы увидите надпись «RFID» внизу. Снимите его, переверните, и вы увидите контрольную диаграмму направленности антенны на задней панели.

Устройства против кражи из магазина решили эту проблему. Так же как с передатчиком и приемником в дверях, каждый предмет в Магазин содержит скрытый РФ «тег».В книжных магазинах и библиотеках вы найдете очень осторожные «мягкие метки», прикрепленные к одной из внутренних страниц. В В музыкальных магазинах пластиковая термоусадочная пленка может быть прикреплена к радиочастотной метке. на него, или компакт-диски могут быть заперты в больших пластиковых корпусах с RF метками встроенный в них, который может быть удален только специальным инструментом на проверять, выписываться. В магазинах одежды, как правило, есть «жесткий тег» (коренастый, круглый, белая пластиковая бирка) прикреплена к каждому предмету острым металлическим шипом (иногда в бирке есть чернила, поэтому она разливается по всему вам и портит предмет, который вы пытаетесь украсть, если попытаетесь его удалить).Некоторые из этих тегов тщательно скрыты, поэтому вы не можете их обнаружить. Другие намеренно очень очевидно и легко увидеть — поэтому они удерживают от кражи. Ворота в дверях (и частые тревоги) являются еще одним очень заметным сдерживающим фактором для магазинных воров.

Если вы идете через дверной проем, ничего не платя, радиоволны от передатчика (спрятаны на одном из ворот) подобраны спиральной металлической антенной на этикетке. Это генерирует крошечный электрический ток, который заставляет метку передавать новый радиосигнал его владеть на очень определенной частоте.Приемник (спрятанный в воротах другой двери) поднимает радиосигнал, который тег передает и звучит сигнал тревоги. Почему не звучит сигнал тревоги, когда вы платите за что-то? Вы возможно, заметили, что продавец-консультант передает ваш товар или через дезактивирующее устройство (иногда оно включено в обычный механизм сканирования штрих-кода, а иногда он совершенно отдельный). Это разрушает или деактивирует электронные компоненты на радиочастотной метке, чтобы они больше не улавливали и не передавали сигнал при прохождении через ворота — и не звучит сигнал тревоги.

В чем разница между метками RF и RFID?

Все это немного сложнее, чем я это представлял, потому что на самом деле есть два совершенно разных типа радиочастотных меток, и они работают немного по-другому. Часто термин «RFID» свободно используется для описания обоих, но между ними есть большая разница: все радиочастотные метки посылают один и тот же простой сигнал и просто сообщают получателю, что что-то присутствует; RFID-метки посылают более сложные сигналы, которые однозначно идентифицируют то, к чему они прикреплены.

RF метки

Это самые простые радиочастотные метки, и они используются главным образом в так называемом электронном видеонаблюдении (EAS) — методе против кражи из магазина, которую я описал выше. Все теги одинаковы, и ни один из них не идентифицирует статьи, к которым они прикреплены. Поэтому в магазине радиочастотные метки отключают сигнал тревоги, когда вы пытайтесь что-то украсть, но механизм будильника не знает , что за ты крадешь, только то, что ты крадешь что-то : нет никакого способа отличить один предмет от другого.

Одна из самых популярных радиочастотных технологий называется акустомагнитная (АМ) . Импульсный луч радиоволн от передатчика попадает на метку, заставляя его излучать точный сигнал радиочастоты. Приемник принимает сигнал, проверяет его правильную частоту, а затем включает сигнал тревоги. Одним из больших преимуществ AM-тегов является то, что их можно сканировать на большом расстоянии и с большой скоростью, что делает их популярными в противоугонных системах (которые имеют только секунды, чтобы получить сигнал от кого-то, идущего или бегущего через дверной проем магазина).

RF метки иногда называют транспондерами или RFID метками без микросхем .

RFID метки

Они более продвинуты и отличаются от простых радиочастотных меток тем, что они однозначно идентифицируют товар, к которому они были прикреплены: радиосигнал, исходящий от изделия к приемнику, содержит цифровой кодированный идентификатор. Вот как работают автоматы самообслуживания в библиотеках: они излучают радиоволны в метку RFID в задней части книги, принимают радиосигнал из книги и декодируют его, чтобы выяснить цифровой код, который однозначно определяет, какую книгу вы хотите проверить.Компьютер, подключенный к сканеру, делает все остальное (поэтому в библиотеке автомат самообслуживания связывается с компьютером библиотеки для обновления основной базы данных всякий раз, когда вы извлекаете или возвращаете книгу). В отличие от меток RF, метки RFID, как правило, работают на гораздо более коротких расстояниях. Некоторые из них на самом деле должны находиться рядом с устройством для чтения, в то время как другие работают на расстоянии 10 см (4 дюйма) или меньше.

Простые RFID-метки описаны как , пассивные . Вместо того, чтобы содержать батареи, они работают полностью, реагируя на входящие радиоволны от сканер или передатчик.В этих радиоволнах достаточно энергии активировать чип RFID. Пассивные метки обычно отправляют и получают сигналы всего несколько сантиметров, но не намного больше. Альтернативная форма технологии RFID, известная как активных меток , содержит более совершенные чипы и крошечные батареи. чтобы привести их в действие. Они могут отправлять и получать сигналы на гораздо большие расстояния.

Фото: пассивный RFID: металлические метки антенны на этой метке RFID видны довольно четко. Этот тип тегов используется в системах самообслуживания библиотек.

Пассивные RFID-меткисодержат всего три компонента:

- Антенна — ловит входящие радиоволны и снова отправляет их обратно.

- Чип — генерирует уникальный код идентификатора для конкретного тега.

- Подложка — материал основы (обычно бумага или пластик) к которому крепятся антенна и чип.

Как видно из этой фотографии, большую часть пространства в метке RFID занимает антенна: овальная форма треки по краю.Антенна должна быть такой большой, чтобы принимать радиоволны от передатчика. и (потому что нет батарей), чтобы преобразовать их в энергию для питания чипа. Сам чип крошечный — иногда такой же маленький, как кончик карандаша. ВЧ-метки, предотвращающие кражу в магазине, часто меньше и проще: вместо того, чтобы нуждаться в чипе для генерации уникального идентификатора, все, что им нужно, — это принимать входящие радиоволны и ретранслировать одну и ту же электромагнитную энергию на другой частоте.

Другое использование для радиочастотных меток

Фото: военные США в настоящее время используют RFID-метки для отслеживания своих огромных запасов оборудования.Здесь военный технолог держит несколько примеров RFID-меток перед плакатом, рекламирующим преимущества этой технологии. Фото Вики Сокол любезно предоставлено ВМС США.

Нельзя винить магазины за желание установить такие системы, особенно когда вы слышите, что около 10 процентов всех «покупателей» совершают кражи. Но остановка магазинных воров это только одна из вещей, для которых мы можем использовать технологию RF, особенно Технология RFID, которая намного сложнее.

В некоторых городах уже используются активные RFID-метки, встроенные в лобовое стекло автомобиля. автоматически собирать плату за проезд по мостам или шоссе, когда проезжают люди.Это избавляет водителей от необходимости тормозить, останавливаться или возиться изменение. Смарт-карты, используемые в автобусах, метро (метро или метро) и других видах общественного транспорта также содержат чипы RFID. Как вы касаетесь смарт-карта на ридере, карта автоматически дебетует ваш счет со стоимостью поездки. Смарт-карты делятся на две категории известных как контактные и бесконтактные в зависимости от того, нужно ли вам карта для читателя или на небольшом расстоянии (и это зависит от тип используемой технологии RFID).Пока какой-то бесконтактный кредит и дебет карты используют RFID, другие используют конкурирующую технологию, называемую ближней связью (NFC), что кратко объяснено в рамке ниже.

Библиотекишироко используют RF и RFID: радиочастотные метки для защиты своих фондов и RFID-метки, позволяющие людям использовать контрольно-кассовые машины самообслуживания. Когда ты проверить книги в библиотеке или из библиотеки на одном из этих компьютеров как он узнает, какую книгу вы заимствуете без необходимости сканировать штрих-код.Ответ в том, что внутри обложки книги находится чип RFID. Когда вы кладете свою книгу на стеклянную пластину, машина читает детали книги мгновенно и автоматически, отправив радиосигнал на чип. С радио волны проходят прямо через картон и бумагу, вам даже не нужно открывать до книги!

RFID-меткимогут стать еще более популярными в будущем. Вскоре у вас может быть чип RFID, встроенный в ваш паспорт для ускорения Ваш проход через порты и аэропорты.Чип RFID, имплантированный под Ваша кожа может спасти вашу жизнь в результате несчастного случая, передавая медицинская информация для команды скорой помощи. Врачи будут просто махать читателем над вашей рукой (или где-нибудь чип был имплантирован), чтобы получить немедленный доступ к вашему медицинские записи. Такие системы, очевидно, вызывают огромную обеспокоенность личная жизнь людей. Имплантированные идентификационные чипы будут отмечать прибытие государства Большого Брата, способного контролировать все, что мы делаем и куда бы мы ни пошли. Хотя могут быть огромные выгоды, большинству людей нужно было бы убедительно принять такой радикальный вторжение в их личную жизнь!

NFC против RFID

Просто когда вы привыкаете к одной технологии, появляется что-то новое! RFID существует уже много лет и, как следует из его названия, в целом на выявление вещей (и людей) с помощью радиоволн.Но это никогда не было на самом деле разработан для мира 21-го века, где люди должны идентифицировать или подключаться к вещам очень специальным образом, часто выходя в Интернет для аутентификации данных или осуществления платежей. И вообще, сейчас большинство из нас носят смартфоны. Зачем нам нужна куча RFID-карт, которые мы должны продолжать пополнять кредитами? Почему бы просто не носить одно устройство, которое делает все, используя набор защищенных приложений, и подключается к Интернету, когда это необходимо?

Для этого у нас есть ближней связи (NFC) , который позволяет смартфонам (или другим устройствам) со встроенными чипами читать, записывать и подключаться к другим ближайшим устройствам NFC (считыватели карт в автобусах или турникеты на спортивных стадионах, например).Использование радиоволн 13,56 мегагерцовой частоты на расстоянии 10 см (4 дюйма) или менее, это что-то вроде сочетания RFID и Bluetooth «спаривания» (способ соединения двух соседних устройств Bluetooth).

Скриншот: Android Pay работает с использованием NFC. Когда NFC включен на телефоне Android, вы видите маленький значок «N» в верхней части экрана рядом с такими вещами, как батарея и состояние сигнала. Вы можете полностью отключить NFC, чтобы сделать ваш телефон более безопасным. На моем телефоне LG я делаю это в меню «Настройки» → «Сети» → «Совместное использование и подключение» → NFC.

Пока что наиболее известным применением NFC являются бесконтактные платежные системы для смартфонов, такие как Android Pay, но в будущем, вероятно, будет гораздо больше приложений — от ключей умного дома (где вы открываете дверь с помощью приложения для телефона) и общественного транспорта. проходит на электронные билеты на рок-концерт и банкоматные карты. Одним из преимуществ NFC над RFID является то, что его можно использовать гораздо чаще с помощью автоматизированных устройств, таких как смартфоны, более или менее автоматически выполнять целый ряд различных задач.Например, Sony внедрила чипы NFC во многие свои новые продукты, чтобы они могли общаться друг с другом и легче обмениваться данными. Что делает проще загружать фотографии с цифровой камеры в социальные сети или просматривать фотографии с камеры на телевизоре. Как NFC приносит больше удобства, так и дополнительные проблемы безопасности и конфиденциальности. Что если устройства NFC других людей начнут считывать данные со смартфона в вашем кармане, когда вы стоите рядом? А как насчет вредоносных программ (вирусы и другой злокачественный код), передаваемых в ваш смартфон от чужого? Что ж, кажется, что каждая новая технология должна приносить как недостатки, так и преимущества!

,Анализ настроений является частью методов обработки естественного языка (NLP), которые заключаются в извлечении эмоций, связанных с некоторыми необработанными текстами. Это обычно используется в сообщениях социальных сетей и отзывах клиентов, чтобы автоматически понять, являются ли некоторые пользователи положительными или отрицательными и почему. Цель этого исследования — показать, как можно выполнить анализ настроений с помощью Python. Вот некоторые из основных библиотек, которые мы будем использовать:

- NLTK: самый известный модуль python для методов НЛП

- Gensim: инструментарий для тематического моделирования и векторного моделирования

- Scikit-learn: наиболее часто используемые библиотека машинного обучения python

Мы будем использовать здесь некоторые отзывы об отелях.Каждое наблюдение состоит из одного отзыва клиента для одного отеля. Каждый отзыв клиента состоит из текстового отзыва об опыте клиента в отеле и общего рейтинга. Данные можно найти здесь:

https://www.kaggle.com/jiashenliu/515k-hotel-reviews-data-in-europe

Для каждого текстового обзора мы хотим предсказать, соответствует ли он хорошему обзору (клиент доволен) или плохой (клиент не удовлетворен). Общий рейтинг отзывов может варьироваться от 2.5/10 до 10/10. Чтобы упростить проблему, мы разделим их на две категории:

- плохих отзывов имеют общие оценки <5

- хороших отзывов имеют общие оценки> = 5

Задача здесь состоит в том, чтобы иметь возможность прогнозировать эту информацию, используя только необработанные текстовые данные из обзора. Начнем!

Сначала мы загружаем необработанные данные. Каждый текстовый обзор делится на положительную и отрицательную части. Мы группируем их вместе, чтобы начать только с необработанных текстовых данных и никакой другой информации.

Исходный набор данныхМы производим выборку данных для ускорения вычислений.

Если пользователь не оставит ни одного комментария с отрицательной обратной связью, он будет отображаться как «Нет отрицательных» в наших данных. То же самое относится и к положительным комментариям со значением по умолчанию «Нет положительных». Мы должны удалить эти части из наших текстов.

Следующий шаг состоит в очистке текстовых данных с помощью различных операций:

Чтобы очистить текстовые данные, мы вызываем нашу пользовательскую функцию «clean_text», которая выполняет несколько преобразований:

- опускаем текст

- разбиваем на текст (разбиваем текст в слова) и удалить пунктуацию

- удалить бесполезные слова, которые содержат цифры

- удалить бесполезные стоп-слова, такие как «the», «a», «this» и т. д.

- теги части речи (POS): присвойте тег каждому слову, чтобы определить, соответствует ли он существительному, глаголу и т. Д., Используя лексическую базу данных WordNet. например комнаты -> комната, сон -> сон)

Теперь, когда мы очистили наши данные, мы можем выполнить некоторые функции для нашей части моделирования.

Сначала мы добавим функции анализа настроений, потому что можем догадаться, что отзывы клиентов тесно связаны с тем, что они думают о пребывании в отеле.Мы используем Vader, который является частью модуля NLTK, предназначенного для анализа настроений. Вейдер использует словарь слов, чтобы найти положительные или отрицательные. Он также учитывает контекст предложений для определения оценок настроения. Для каждого текста Вейдер возвращает 4 значения:

- балл нейтральности

- балл позитива

- балл негатива

- общий балл, который суммирует предыдущие баллы

Мы интегрируем эти 4 значения как функции в нашем наборе данных.

Далее мы добавляем несколько простых метрик для каждого текста:

- количество символов в тексте

- количество слов в тексте

Следующий шаг состоит в извлечении векторных представлений для каждого обзора. Модуль Gensim создает числовое векторное представление каждого слова в корпусе, используя контексты, в которых они появляются (Word2Vec). Это выполняется с помощью неглубоких нейронных сетей. Интересно то, что похожие слова будут иметь похожие векторы представления.

Каждый текст также можно преобразовать в числовые векторы, используя векторы слов (Doc2Vec). Одинаковые тексты также будут иметь схожие представления, и поэтому мы можем использовать эти векторы в качестве обучающих функций.

Сначала мы должны обучить модель Doc2Vec, введя наши текстовые данные. Применяя эту модель в наших обзорах, мы можем получить эти векторы представления.

Наконец мы добавляем значения TF-IDF (Term Frequency — Inverse Frequency) для каждого слова и каждого документа.

Но почему бы просто не посчитать, сколько раз каждое слово встречается в каждом документе? Проблема этого метода заключается в том, что он не учитывает относительную важность слов в текстах. Слово, которое встречается почти в каждом тексте, вряд ли принесет полезную информацию для анализа. Наоборот, редкие слова могут иметь гораздо больше значений.

Метрика TF-IDF решает эту проблему:

- TF вычисляет классическое число раз, когда слово появляется в тексте

- IDF вычисляет относительную важность этого слова, которая зависит от того, сколько текстов слово может быть найдено

Мы добавляем столбцы TF-IDF для каждого слова, которое появляется как минимум в 10 различных текстах, чтобы отфильтровать некоторые из них и уменьшить размер конечного вывода.

Чтобы лучше понять наши данные, давайте немного их изучим:

0 0.956761

1 0.043239

Имя: is_bad_review, dtype: float64

Наш набор данных сильно несбалансирован, потому что менее 5% наших обзоров считаются негативными. Эта информация будет очень полезна для части моделирования.

Теперь давайте напечатаем некоторые облака слов, чтобы иметь представление о том, какие слова встречаются в наших обзорах:

WordCloud из отзывов клиентовБольшинство слов действительно относятся к отелям: комната, персонал, завтрак и т. Д.Некоторые слова в большей степени связаны с впечатлениями клиентов от пребывания в отеле: идеальный, любимый, дорогой, неприязнь и т. Д.

Высочайшие положительные отзывыНаиболее положительные отзывы действительно соответствуют некоторым хорошим отзывам.

Отзывы о самых негативных настроенияхНекоторые ошибки можно найти среди самых негативных отзывов: Вейдер иногда интерпретирует «нет» или «ничего» как негативные слова, тогда как иногда они говорят, что с отелем проблем не было. К счастью, большинство обзоров действительно плохие.

Распределение настроенийНа приведенном выше графике показано распределение настроений по отзывам между хорошими и плохими отзывами. Мы видим, что хорошие отзывы для большинства из них признаны Вейдером очень положительными. Напротив, плохие отзывы, как правило, имеют более низкие оценки сложного настроения.

Это показывает нам, что ранее вычисленные особенности настроения будут очень важны в нашей части моделирования.

Сначала мы выбираем, какие функции мы хотим использовать для обучения нашей модели. Затем мы разбиваем наши данные на две части:

- одна, чтобы обучить нашу модель

- одна, чтобы оценить ее производительность

Далее мы будем использовать классификатор Random Forest (RF) для наших прогнозов.

Наиболее важные функцииНаиболее важными функциями действительно являются те, которые получены из предыдущего анализа настроений. Векторные представления текстов также имеют большое значение в нашем обучении. Некоторые слова, по-видимому, также имеют довольно важное значение.

Кривая ROCКривая ROC (рабочая характеристика приемника) обычно является хорошим графиком для подведения итогов качества нашего классификатора. Чем выше кривая выше диагональной базовой линии, тем лучше прогнозы. Хотя AUC ROC (область под кривой ROC) очень хорошая, мы не должны здесь использовать кривую ROC для оценки качества нашей модели.

Почему? Для начала напомним формулу ложной положительной ставки, которая соответствует оси x кривой ROC: FPR (ложная положительная ставка) = # ложных положительных / # отрицательных.

Здесь # Negatives соответствует нашему количеству хороших отзывов, которое очень велико, потому что наш набор данных несбалансирован. Это означает, что даже с некоторыми ложными срабатываниями наш FPR будет оставаться очень низким. Наша модель сможет делать много ложных положительных прогнозов и по-прежнему иметь низкий уровень ложных срабатываний, в то же время увеличивая истинный положительный показатель и, следовательно, искусственно увеличивая показатель AUC ROC.

Кривая PRЛучшим показателем в этой несбалансированной ситуации является PR AUC (Площадь под отзывом точности кривой), или также называемый AP (Средняя точность).

Мы можем видеть, что точность уменьшается, когда мы увеличиваем отзыв. Это показывает нам, что мы должны выбрать порог прогноза, адаптированный к нашим потребностям. Если наша цель состоит в том, чтобы иметь высокий отзыв, мы должны установить низкий порог предсказания, который позволит нам обнаруживать большинство наблюдений положительного класса, но с низкой точностью.Напротив, если мы хотим быть действительно уверенными в наших прогнозах, но не беспокоиться о том, чтобы не найти все положительные наблюдения, мы должны установить высокий порог, который даст нам высокую точность и низкий отзыв.

Чтобы узнать, работает ли наша модель лучше, чем другой классификатор, мы можем просто использовать метрику AP. Чтобы оценить качество нашей модели, мы можем сравнить ее с простым базовым решением. Давайте возьмем случайный классификатор в качестве базовой линии, который будет предсказывать половину времени 1 и половину времени 0 для метки.

Такой классификатор будет иметь точность 4,3%, что соответствует доле положительных наблюдений. Для каждого значения отзыва точность осталась бы прежней, и это привело бы к точке доступа 0,043. AP нашей модели составляет приблизительно 0,35, что более чем в 8 раз выше, чем AP случайного метода. Это означает, что наша модель обладает хорошей предсказательной силой.

Вполне возможно использовать только необработанный текст в качестве входных данных для прогнозирования. Самое главное, чтобы можно было извлечь соответствующие функции из этого необработанного источника данных.Данные такого типа часто могут стать хорошим дополнительным источником в проектах по науке о данных, чтобы извлечь больше возможностей для обучения и повысить предсказательную силу моделей.

Вот ссылка на оригинальный блокнот Jupyter на Github:

Также на Kaggle:

Мой профиль в LinkedIn:

https://www.linkedin.com/in/jonathanoheix/

.I. Латентное распределение Дирихле

Наиболее популярный алгоритм моделирования тем — LDA, Латентное распределение Дирихле . Давайте сначала распутаем это внушительное имя, чтобы понять, что оно делает.

- Латент , потому что темы «скрыты». У нас есть куча текстов, и мы хотим, чтобы алгоритм помещал их в кластеры, которые будут иметь для нас смысл. Например, если наши текстовые данные поступают из новостного контента, обычно найденные кластеры могут быть о политике Ближнего Востока, компьютере, космосе … но мы пока не знаем этого.

- Dirichlet расшифровывается как дистрибутив Dirichlet, который модель использует в качестве предварительного для создания дистрибутивов по темам документов и по темам.

- Распределение , потому что мы хотим выделить темы для наших текстов.

На рисунке 1 ниже показано, как шаги LDA четко формулируют темы в совокупности документов.

Рисунок 1. Процесс создания документов LDA с использованием дистрибутива Dirichlet.«Документ создается путем выборки смеси этих тем и последующего отбора слов из этой смеси» (Эндрю Нг, Дэвид Блей и Майкл Джордан из оригинальной LDA , бумага ).

NB : На рисунке 1 выше мы установили K = 3 темы и N = 8 слов в нашем словаре для простоты иллюстрации. Мы также назвали эти темы «Компьютер, космос и политика Ближнего Востока» для простоты иллюстрации (вместо того, чтобы называть их темой 1, темой 2 и темой 3). На самом деле, нашей задачей будет понять, что 3 найденные темы касаются политики в области компьютеров, космоса и ближнего востока относительно их содержания (мы рассмотрим эту часть более подробно при атрибуции тем нашего конвейера STTM в части III).

Короче говоря, LDA, используя дистрибутивы Dirichlet в качестве предшествующего знания, генерирует документы, составленные по темам, а затем обновляет их, пока они не соответствуют основополагающей истине.

II. Моделирование коротких текстовых тем (STTM)

Несмотря на отличные результаты для текстов среднего или большого размера (> 50 слов), обычно почтовые и новостные статьи примерно такого же размера, LDA плохо работает с короткими текстами , такими как твиты, посты Reddit или Вопросы заголовков StackOverflow.

Рисунок 2. Пример коротких текстов и темы, которую они обсуждают.Из приведенных выше примеров коротких текстов на рис. 2 видно, что предположение о том, что текст представляет собой смесь тем (помните первый шаг на рис. 1), больше не соответствует действительности. Предположим теперь, что краткий текст из состоит только из одной темы .

Модель ( GSDMM ) ( GSDMM ) представляет собой «измененный» алгоритм LDA, который демонстрирует отличные результаты при выполнении задач STTM, что делает первоначальное предположение: 1 тема document1 документ . Слова в документе генерируются с использованием той же уникальной темы, а не из смеси тем, как это было в оригинальном LDA.

Прежде чем углубляться в код и практические аспекты, давайте разберемся в GSDMM с эквивалентной процедурой, называемой Movie Group Process , которая поможет нам понять различные этапы и процессы, находящиеся под капотом STTM, и способы эффективной настройки его гипер. -параметры (мы помним альфа и бета из части LDA).

Представьте себе группу студентов в ресторане, случайным образом сидящих за столами K. Их всех просят написать свои любимые фильмы на бумаге (но это должен остаться короткий список).Цель состоит в том, чтобы объединить их в группы таким образом, чтобы учащиеся в одной группе имели одинаковые интересы в кино. Для этого один за другим учащиеся должны сделать новый выбор столов в соответствии с двумя следующими правилами:

- Правило 1. Выберите стол с большим количеством учеников. Это правило улучшает полноту , все учащиеся, разделяющие интерес к одному фильму, назначаются на одну таблицу.

- Правило 2: Выберите стол, где учащиеся разделяют интерес фильма. Это правило направлено на повышение однородности и , мы хотим, чтобы только участники, разделяющие интерес одного и того же фильма, за столом.

После повторения этого процесса мы ожидаем, что некоторые таблицы исчезнут, а другие станут больше и, в конечном итоге, группы учащихся будут соответствовать интересам их фильмов. Это просто то, что делает алгоритм GSDMM!

III. Реализация STTM

В этой части мы построим полный конвейер STTM из конкретного примера, используя набор данных из 20 групп новостей из Scikit-learn, используемый для моделирования тем на текстах.

Первым делом нам нужно скачать скрипт STTM с Github в папку нашего проекта.

cd sttm_project

git clone https://github.com/rwalk/gsdmm.git

Теперь мы можем приступить к реализации конвейера STTM (вот статическая версия ноутбука, который я использовал).

# Полезные библиотеки

из набора sklearn.datasets более подробно опишем позже

из предварительной обработки, импортируйте токен

из topic_allocation import top_words, topic_attribution

из визуализации import plot_topic_notebook # Загрузите набор данных 20NewsGroups из sklearn

cats = ['talk.policy.mideast ',' comp.windows.x ',' sci.space ']

newsgroups_train = fetch_20newsgroups (subset =' train ', Categories = cats)

Однако в этом упражнении мы не будем использовать весь контент новости, чтобы экстраполировать тему из нее, но учитывает только тему и первое предложение новостей (см. рисунок 3 ниже). Действительно, нам нужны короткие тексты для моделирования тем коротких текстов… очевидно,

Кроме того, мы рассмотрим только 3 темы (равномерно распределенные по набору данных) для простоты иллюстрации.Это следующие темы:

- Политика Ближнего Востока 🌍

- Космос 👾

- Windows X 🖥

# Предварительная обработка и токенизация

tokenized_data = tokenize (df, form_reduction = 'stemming' ,realt = False)

Вот рецепт предварительной обработки, который я выполнил для этой задачи:

- Токенизация с использованием токенайзера spaCy.

- Удаление стоп-слов и слов из 1 символа.

- Стемминг (учитывая мой эмпирический опыт, который я наблюдал, стемминг дает лучшие кластеры на коротком тексте по сравнению с лемматизацией) с использованием стеммера библиотеки nltk.

- Удаление пустых документов и документов с более чем 30 токенами.

- Удаление уникального токена (с частотой членов = 1).

Однако следует иметь в виду, что предварительная обработка зависит от данных и следует рассмотреть возможность адаптации другого подхода предварительной обработки, если используется другой набор данных.

Теперь, когда наши данные очищены и обработаны в правильном формате ввода, мы готовы обучить модель 000

# Train STTM model # Инициализация алгоритма модели выборки Гиббса Dirichlet

# K = число потенциальных тем (которые мы априори не знаем)

# alpha =

# beta =

# n_iters = количество итераций до

mgp = MovieGroupProcess (K = 10, alpha = 0.1, бета = 0,1, n_iters = 30) vocab = set (x для документа в документах для x в документе)

n_terms = len (vocab) y = mgp.fit (документы, n_terms) # Сохранить модель

с открытым ('dumps) /trained_models/v1.model ', «wb») как f:

pickle.dump (mgp, f)

f.close ()

Давайте погрузимся в капот и разберемся в механике гиперпараметров модели GSDMM 🛠:

- K = 10. В реальном случае нам неизвестно точное количество тем, поэтому мы хотим выбрать более высокое значение. Теоретически, GSDMM должен очистить бесполезные кластеры и в конечном итоге найти точное количество кластеров.Это не будет иметь место здесь, но не о чем беспокоиться, мы объясним ситуацию более подробно позже.

- альфа = 0,1 и бета = 0,1. Здесь мы сохранили параметры по умолчанию (которые хорошо работают для нескольких наборов данных). Тем не менее, можно настроить их на улучшение распределения тем по полноте и однородности кластеров. Не стесняйтесь обращаться к оригинальному документу, чтобы понять баланс между этими двумя параметрами.

- n_iters = 30.Согласно оригинальной статье, GSDMM сходится довольно быстро (около 5 итераций) в нескольких наборах данных и остается очень стабильным. Следовательно, 30 итераций — это хорошее значение по умолчанию для любого типа набора данных.

После того, как модель обучена, мы хотим изучить найденные темы и проверить, соответствуют ли они их содержанию.

Учитывая, что наша модель собрала документы в 10 тем, мы должны дать им имя, которое будет иметь смысл относительно их содержания. Итак, давайте углубимся в темы, найденные нашей моделью.

doc_count = np.array (mgp.cluster_doc_count)

print ('Количество документов по теме:', doc_count)

print ('*' * 20) # Темы отсортированы по номеру документа, которому они выделены

top_index = doc_count.argsort () [- 10:] [:: - 1]

print ('Самые важные кластеры (по количеству документов внутри):', top_index)

print ('*' * 20) # Показать первые 5 слов в терминах частоты для каждого кластера

top_words (mgp.cluster_word_distribution, top_index, 5)

Приведенный выше код отображает следующую статистику, которая дает нам представление о том, из чего состоят наши кластеры.

Рисунок 5: 1) Количество документов по кластерному (или тематическому) индексу. 2) Сортированный список кластеров по количеству документов, которые они содержат. 3) Лучшие 5 слов относительно их частоты внутри кластера.В идеале алгоритм GSDMM должен находить правильное количество тем, здесь 3, а не 10. Мне приходят на ум три объяснения:

- Найти другие гиперпараметры, чтобы очистить меньший кластер (для более глубокого понимания альфа обратитесь к оригинальной статье. и бета-параметры).

- У нас есть небольшой набор данных и словарь (около 1700 документов и 2100 слов), что может быть затруднительно для модели для экстраполяции и различения существенных различий между темами.Как обычно, чем больше данных, тем лучше.

- Алгоритм может найти темы внутри тем. Позволь мне объяснить. Как мы хорошо знаем, одна из тем — о ближневосточных новостях. Однако алгоритм разбил эту тему на 3 подтемы: напряженность между Израилем и Хезболлой (кластер 7), напряженность между турецким правительством и Арменией (кластер 5) или сионизм в Израиле (кластер 0).

Однако, даже если найдено более 3 кластеров, совершенно очевидно, как мы можем назначить их для соответствующей общей темы.

# Должно быть сделано вручную, чтобы названия тем соответствовали вышеуказанным кластерам

# (рисунок 5) относительно их содержимогоtopic_dict = {}

topic_names = ['x',

'mideast',

'x',

'space',

«пробел»,

«ближний восток»,

«пробел»,

«пробел»,

«ближний восток»,

«пробел»] для i, topic_num в перечислении (top_index):

topic_dict [topic_num] = topic_names [i] df_pred = topic_attribution (tokenized_data, mgp, topic_dict, threshold = 0.4)

Кто-то может спросить, что является порогом для входного параметра для функции topic_attribution .Фактически, темы назначаются тексту с учетом вероятности, и topic_attribution является пользовательской функцией, которая позволяет выбрать, какой порог (степень достоверности) следует учитывать, чтобы принадлежать теме. Например, если посмотреть на распределение вероятности темы по тексту, если эта вероятность ниже 0,4, текст будет размещен в теме «Другие».

NB : Эта пользовательская функция topic_attribution построена на основе исходной функции, доступной в пакете GSDMM: choose_best_label, , которая выводит тему с наибольшей вероятностью принадлежности к документу.

Теперь пришло время выделить найденную тему в документах и сравнить ее с основополагающей правдой (✅ против ❌).

df_pred [['content', 'topic_name', 'topic_true_name']]. Head (20)

Наивно сравнивая предсказанные темы с реальными темами, мы получили бы с 82% точностью ! 🎯

Только с 9 словами, в среднем по документам, небольшим корпусом из 1705 документов и очень немногими настройками гиперпараметров!

Приятно иметь эффективную модель, но еще лучше, если мы можем просто показывать и взаимодействовать с ее результатами.Для этого pyLDAvis — очень мощный инструмент для визуализации моделирования тем, позволяющий динамически отображать кластеры и их содержимое в двухмерном пространстве.

Снимок экрана со способностью pyLDAvis. Проверьте это видео, чтобы увидеть его полную мощность.Теперь ваша очередь попробовать это на ваших собственных данных (комментарии в социальных сетях, ответы в онлайн-чатах…))

Et voilà! 000

Я хотел бы поблагодарить Раджа Эль Хамдани за отзыв и отзыв.

.Машинное обучение — Обработка текста | Javaid Nabi

Обработка текста — одна из самых распространенных задач во многих ML-приложениях. Ниже приведены некоторые примеры таких приложений.

• Языковой перевод: перевод предложения с одного языка на другой. • Анализ настроения: по текстовому корпусу определить, является ли настроение по отношению к какой-либо теме, продукту и т. Д. Положительным, отрицательным или нейтральным. • Фильтрация спама: обнаружение нежелательных и нежелательных писем / сообщений.Вежливость (сигмоидальная)

Эти приложения имеют дело с огромным количеством текста для выполнения классификации или перевода и включают в себя много работы на серверной части. Преобразование текста во что-то, что алгоритм может переварить, является сложным процессом. В этой статье мы обсудим этапы обработки текста.

Шаг 1. Предварительная обработка данных

- Токенизация — преобразование предложений в слова

- Удаление ненужных знаков препинания, тегов

- Удаление стоп-слов — часто встречающиеся слова, такие как «the», «is» и т. Д.которые не имеют специфической семантики

- Основа — слова сокращаются до корня путем удаления перегиба путем удаления ненужных символов, обычно суффикса.

- Лемматизация — еще один подход к устранению перегиба путем определения части речи и использования подробной базы данных языка.

Основная форма обучения: studi

Основная форма обучения: исследование. Лемматизированная форма обучения: исследование

. Лемматизированная форма обучения: исследование

. «учиться» на общую базовую форму или корень слова «учиться».Подробное обсуждение стемминга и лемматизации см. Здесь. Обратите внимание, что не все шаги являются обязательными и основаны на сценарии использования приложения. Для фильтрации спама мы можем выполнить все вышеперечисленные шаги, но не для языкового перевода.

Мы можем использовать python для выполнения многих операций предварительной обработки текста.

- NLTK — набор инструментов Natural Language Toolkit — одна из самых известных и наиболее часто используемых библиотек NLP, полезная для всех видов задач, начиная с токенизации, определения границ, тегов, анализа и далее

- BeautifulSoup — библиотека для извлечения данных из Документы HTML и XML

# Используя библиотеку NLTK, мы можем выполнить большую часть текста, предварительно обработав

import nltk

из nltk.tokenize import word_tokenize

# функция разделения текста на слова

tokens = word_tokenize («Быстрая коричневая лиса перепрыгивает через ленивую собаку»)

nltk.download («стоп-слова»)

print (токены)

OUT: [ ‘The’, ‘quick’, ‘brown’, ‘fox’, ‘jumps’, ‘over’, ‘the’, ‘lazy’, ‘dog’]

из nltk.corpus импорт стоп-слов

stop_words = set ( stopwords.words ('english'))

токенов = [w для w в токенах, если не w в stop_words]

print (токены)

OUT: [‘The’, ‘quick’, ‘brown’, ‘fox’ , ‘jumps’, ‘lazy’, ‘dog’]

#NLTK предоставляет несколько интерфейсов стеммера, таких как стемер Портера, #Lancaster Stemmer, Snowball Stemmer

от nltk.stem.porter импорт PorterStemmer

porter = PorterStemmer ()

стеблей = []

для т в токенах:

stems.append (porter.stem (t))

отпечаток (стебли)

OUT: [‘the’, ‘ quick ‘,’ brown ‘,’ fox ‘,’ jump ‘,’ lazi ‘,’ dog ‘]

Шаг 2. Извлечение признаков

При обработке текста слова текста представляют отдельные, категоричные признаки. Как мы кодируем такие данные таким образом, чтобы их можно было использовать в алгоритмах? Сопоставление текстовых данных с реальными векторами называется извлечением признаков.Один из самых простых методов численного представления текста — Bag of Words.

Мешок слов (BOW): Мы составляем список уникальных слов в текстовом корпусе, который называется словарь. Затем мы можем представить каждое предложение или документ в виде вектора, где каждое слово представлено как 1 для настоящего и 0 для отсутствующего в словаре. Другое представление может быть подсчитано, сколько раз каждое слово появляется в документе. Наиболее популярным подходом является использование Term Frequency Inverse Document Frequency (TF-IDF) метод.

- Term Frequency (TF) = (Количество раз, когда термин t появляется в документе) / (Количество терминов в документе)

- Inverse Document Frequency (IDF) = log (N / n), где , N — количество документов, а n — количество документов, в которых появился термин t. IDF редкого слова высок, тогда как IDF часто встречающегося слова, вероятно, будет низким. Таким образом, эффект выделения слов, которые различны.

- Мы вычисляем TF-IDF значение термина как = TF * IDF

Давайте рассмотрим пример для вычисления TF-IDF термина в документе.

Пример текстового корпуса TF ('Beautiful', Document1) = 2/10, IDF ('Beautiful') = log (2/2) = 0

TF ('day', Document1) = 5/10, IDF ( 'day') = log (2/1) = 0,30 TF-IDF («Beautiful», Document1) = (2/10) * 0 = 0

TF-IDF («day», Document1) = (5/10 ) * 0,30 = 0,15

Как видно из документа 1, метод TF-IDF сильно штрафует слово «красивая», но придает больший вес «дню». Это связано с частью IDF, которая дает больший вес отдельным словам.Другими словами, «день» является важным словом для Document1 в контексте всего корпуса. Библиотека Python scikit-learn предоставляет эффективные инструменты для интеллектуального анализа текстовых данных и предоставляет функции для вычисления TF-IDF текстового словаря с учетом текстового корпуса.

Одним из основных недостатков использования BOW является то, что он отбрасывает порядок слов, игнорируя тем самым контекст и, в свою очередь, значение слов в документе. Для обработки естественного языка (NLP) поддержание контекста слов имеет первостепенное значение.Для решения этой проблемы мы используем другой подход, который называется Word Embedding.

Вложение слов: Это представление текста, где слова, имеющие одинаковое значение, имеют похожее представление. Другими словами, он представляет слова в системе координат, где связанные слова, основанные на совокупности отношений, располагаются ближе друг к другу.

Давайте обсудим некоторые из хорошо известных моделей встраивания слов :

Word2Vec

Word2vec принимает в качестве входных данных большой набор текста и создает векторное пространство, в котором каждому уникальному слову присваивается соответствующий вектор в космос.Векторы слов расположены в векторном пространстве так, что слова, которые имеют общий контекст в корпусе, расположены в непосредственной близости друг от друга в пространстве. Word2Vec очень хорошо знает смысл и демонстрирует его в таких задачах, как вычисление вопросов аналогии в форме , а — это , b , как , — это ? Например, мужчина для женщина , а дядя для ? ( тетя ) с использованием простого метода смещения вектора на основе косинусного расстояния.Например, вот смещения вектора для трех пар слов, иллюстрирующие гендерное отношение:

смещения вектора для гендерного отношенияЭтот вид векторного состава также позволяет нам ответить «Король — Мужчина + Женщина =?» вопрос и получите результат «королева»! Все это поистине замечательно, когда вы думаете, что все эти знания просто получены от просмотра множества слов в контексте без какой-либо другой информации об их семантике. Для более подробной информации обратитесь сюда.

Glove

Алгоритм глобальных векторов для представления слов, или GloVe, является расширением метода word2vec для эффективного изучения векторов слов.GloVe создает явную матрицу контекста слова или слова вхождения, используя статистику по всему текстовому корпусу. В результате получается модель обучения, которая может привести к улучшению вложения слов.

Рассмотрим следующий пример:

Целевые слова: лед, пар

Пробные слова: твердое тело, газ, вода, мода

Пусть P (k | w) будет вероятностью того, что слово k появляется в контексте слова w . Рассмотрим слово, тесно связанное с льда , но не с паром , например твердое тело . P (твердый | лед) будет относительно высоким, а P (твердый | пар) будет относительно низким. Таким образом, отношение P (твердое вещество | лед) / P (твердое вещество | пар) будет большим. Если мы возьмем такое слово, как газ , которое относится к пару , но не к льду , отношение P (газ | лед) / P (газ | пар) вместо этого будет небольшим. Для слова, относящегося как к льду , так и к пару , такому как вода , мы ожидаем, что отношение будет близко к единице.Обратитесь сюда для получения более подробной информации.

Вложения слов кодируют каждое слово в вектор, который фиксирует какое-то отношение и сходство между словами в текстовом корпусе. Это означает, что даже такие слова, как регистр, орфография, пунктуация и т. Д., Будут автоматически выучены. В свою очередь это может означать, что некоторые из этапов очистки текста, описанных выше, могут больше не потребоваться.

Шаг 3. Выбор алгоритмов ML

Существуют различные подходы к построению моделей ML для различных текстовых приложений в зависимости от того, что является проблемным пространством и доступными данными.

Классические подходы ML, такие как «Наивный Байес» или «Машины опорных векторов» для фильтрации спама, широко используются. Методы глубокого обучения дают лучшие результаты для проблем НЛП, таких как анализ настроений и языковой перевод. Модели глубокого обучения очень медленны в обучении, и было видно, что для простых задач классификации текста классические подходы к ОД также дают схожие результаты с меньшим временем обучения.

Давайте построим Sentiment Analyzer на основе набора данных обзора фильмов IMDB, используя методы, обсуждавшиеся до сих пор.

Загрузить данные обзора фильма IMDb

Набор обзора фильма IMDB можно загрузить здесь. Этот набор данных для классификации бинарных настроений содержит набор из 25 000 высокополярных обзоров фильмов для обучения и 25 000 для тестирования. Этот набор данных был использован для очень популярной статьи «Изучение векторов слов для анализа настроений».

Предварительная обработка

Набор данных структурирован как набор тестов и обучающий набор из 25000 файлов каждый. Давайте сначала прочитаем файлы в файл данных Python для дальнейшей обработки и визуализации.Набор для тестирования и обучения дополнительно разделен на 12500 «положительных» и «отрицательных» отзывов каждый. Мы читаем каждый файл и помечаем отрицательный отзыв как «0», а положительный отзыв как «1» {‘pos’: 1, ‘neg’: 0} df = pd.DataFrame () для f in (‘test’, ‘train’):

для l in (‘pos’, ‘neg’) :

путь = os.path.join (папка, f, l)

для файла в ОС.listdir (путь):

с открытым (os.path.join (путь, файл), ‘r’, encoding = ‘utf-8’) в качестве infile:

txt = infile.read ()

df = df.append ( [[txt, tags [l]]], ignore_index = True) df.columns = [‘review’, ‘sentiment’]

Давайте сохраним собранные данные в виде файла .csv для дальнейшего использования.

Пять обзоров и соответствующее мнение Чтобы получить частотное распределение слов в тексте, мы можем использовать функцию nltk.FreqDist () , которая перечисляет главные слова, используемые в тексте, предоставляя приблизительное представление о главных Тема в текстовых данных, как показано в следующем коде:

импорт nltk

из nltk.tokenize import word_tokenize reviews = df.review.str.cat (sep = '') #функция разделения текста на слово

tokens = word_tokenize (reviews) словарь = набор (токены)

print (len (словарь) )) имя_частоты = nltk.FreqDist (токены)

отсортировано (частота_дист, ключ = частота_данных .__ getitem__, reverse = True) [0:50]

Это дает 50 лучших слов, используемых в тексте, хотя это очевидно что некоторые из стоп-слов, такие как и , часто встречаются в английском языке.

Присмотритесь, и вы найдете много ненужных знаков препинания и тегов. Исключая одно- и двухбуквенные слова, стоп-слова, такие как , , , это , и , , что занимают верхнюю позицию в графике распределения частоты слов, показанном ниже.

Давайте уберем стоп-слова для дальнейшей очистки текстового корпуса.

из nltk.corpus импорт стоп-слов stop_words = set (stopwords.words ('english'))

токенов = [w для w в токенах, если не w в stop_words] Лучшие 50 слов Это выглядит как очищенный текстовый корпус теперь и такие слова, как , , , , , фильм и т. д.взяв верхние слоты, как и ожидалось.

Еще один полезный инструмент визуализации Пакет wordcloud помогает создавать облака слов путем случайного размещения слов на холсте с размерами, пропорциональными их частоте в тексте.

из wordcloud импортировать WordCloud

импортировать matplotlib.pyplot как plt wordcloud = WordCloud ().

generate_from_frequencies (Frequency_Dist) plt.imshow (wordcloud)

plt.axis ("off")

plt.show ()

Построение классификатора

После очистки пришло время построить классификатор для определения настроения каждый фильм обзор.Из набора данных IMDb разделите наборы тестов и тренировок по 25000 каждый:

X_train = df.loc [: 24999, 'review']. Values

y_train = df.loc [: 24999, 'sentiment']. Values

X_test = df.loc [25000 :, 'review']. values

y_test = df.loc [25000 :, 'sentiment']. values

scikit-learn предоставляет несколько классных инструментов для предварительной обработки текста. Мы используем TfidTransformer , чтобы преобразовать корпус текста в векторы объектов, мы ограничиваем максимальное количество объектов до 10000.Более подробную информацию о том, как использовать TfidTransformer , смотрите здесь.

из sklearn.feature_extraction.text import TfidfTransformerТренировочный и тестовый набор: 25 КБ с 10 КБ Особенности

из sklearn.feature_extraction.text import TfidfVectorizer vectorizer = TfidfVectorizer ()

train_vectors = vectorizer.fit_transform (train_t_vector 900__transform_t_transform) shape, test_vectors.shape)

Можно выбирать из множества алгоритмов, мы будем использовать базовый наивный байесовский классификатор и обучать модель на тренировочном наборе.

от sklearn.naive_bayes import MultinomialNB clf = MultinomialNB (). Fit (train_vectors, y_train)

Наш анализатор настроений готов и обучен. Теперь давайте проверим производительность нашей модели на тестовом наборе, чтобы предсказать метки настроения.

от sklearn.metrics import precision_score прогнозируемый = clf.predict (test_vectors) print (precision_score (y_test, прогнозируемый)) Выход 0,791

Wow !!! Анализатор настроений, основанный на классификаторе NB, хорошо справляется с точностью около 79%.Вы можете попробовать изменить длину вектора признаков и различные параметры TfidTransformer , чтобы увидеть влияние на точность модели.

Заключение: Мы подробно обсудили методы обработки текста, используемые в НЛП. Мы также продемонстрировали использование обработки текста и построили Sentiment Analyzer с классическим подходом ML, достигшим довольно хороших результатов.

Спасибо за чтение этой статьи, рекомендую и поделитесь, если вам это нравится.

Дополнительная литература:

.Check Also

Психологические особенности детей 5-6 лет: что нужно знать родителям

Как меняется поведение ребенка в 5-6 лет. На что обратить внимание в развитии дошкольника. Какие …

Бизнес-Блог Блоготей Бизнес-Блог «Блоготей» — информационный блог о бизнесе и финансах. Полезные статьи и новости из мира бизнеса, финансов, банков, экономики, инвестиций.

Бизнес-Блог Блоготей Бизнес-Блог «Блоготей» — информационный блог о бизнесе и финансах. Полезные статьи и новости из мира бизнеса, финансов, банков, экономики, инвестиций.